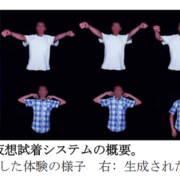

東京大学が多様な体形や姿勢に対応したアパレル向け仮想試着システムを開発

マーケティング最新

マーケティング最新東京大学大学院情報理工学系研究科創造情報学専攻の五十嵐健夫研究室が、リアルタイムで高品質な仮想試着を実現する手法を開発した。

特定衣服の画像の生成に対象を絞って深層学習モデルを構築、さまざまな体形や姿勢に対応した試着画像の生成を実現。深層学習モデルの構築に必要な大量の訓練データを自動的に取得するために、体形や姿勢を自動制御できる訓練データ撮影専用のロボットマネキンを開発した。

この手法を用いると、試着室で鏡を見ているような感覚で仮想的な試着をすることができるようになる。オンラインショッピングで好みに合った商品の選択、ビデオ会議で身体を動かしても違和感のないような仮想的な衣服を合成表示することが可能になる。

仮想試着を実現する手法を開発

開発したシステムのポイント

顧客が計測用の衣服を着てカメラの前に立つと、商品の衣服を着た画像をリアルタイムで生成

ロボットマネキンを利用して体形と姿勢を変えながら大量の画像を撮影し学習、高品質な画像の生成を実現

仮想試着の技術を生かし、オンラインショッピングでさまざまなサイズや種類の商品を試着し適切な商品を選択することなどが可能

画像生成結果の例

計測服を着た試着者の様子はディスプレイの前に置かれた深度センサ付きカメラによって撮影。計測服は体の部位を大まかに示す、いくつかの色によって構成されており、試着者の画像は深度と色の情報を元に、

コメント